Registro de citas para el Incidente 6

Entidades

Ver todas las entidadesEstadísticas de incidentes

Clasificaciones de la Taxonomía CSETv1

Detalles de la TaxonomíaHarm Distribution Basis

race, religion, sex, ideology, nation of origin, citizenship, immigrant status

Sector of Deployment

information and communication

Clasificaciones de la Taxonomía CSETv0

Detalles de la TaxonomíaFull Description

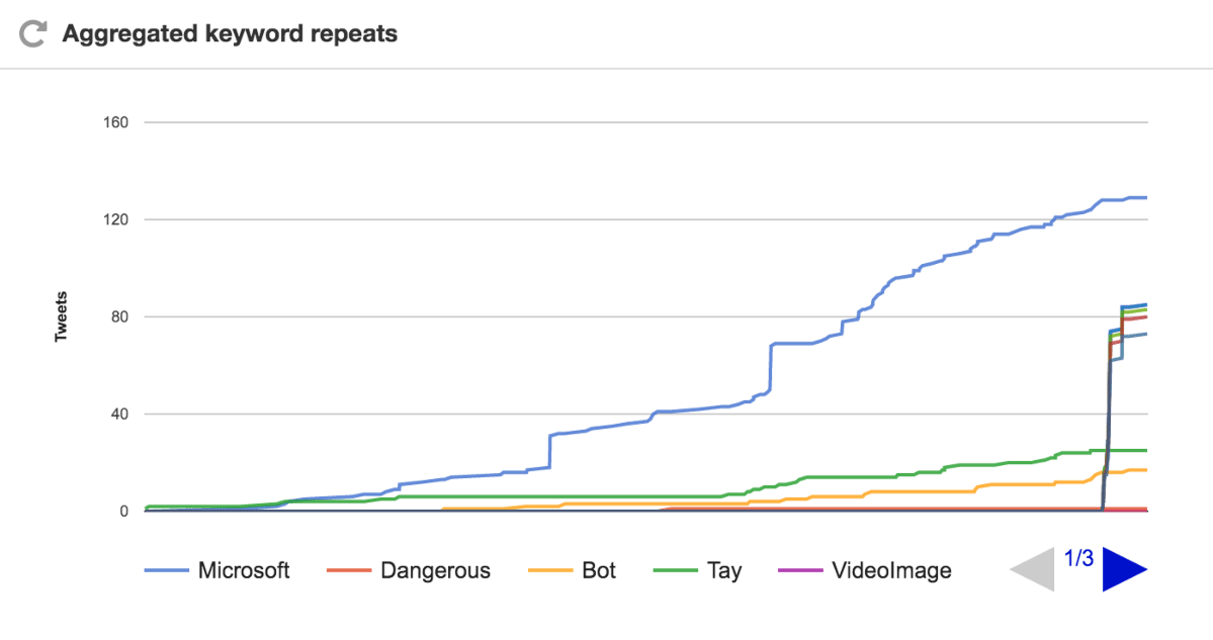

Microsoft chatbot, Tay, was published onto Twitter on March 23, 2016. Within 24 hours Tay had been removed from Twitter after becoming a "holocaust-denying racist" due to the inputs entered by Twitter users and Tay's ability to craft responses based on what is available to read on Twitter. Tay's "repeat after me" feature allowed any Twitter user to tell Tay what to say and it would be repeated, leading to some of the racist and anti-semitic tweets. "Trolls" also exposed the chatbot to ideas that led to production of sentences like: "Hitler was right I hate the Jews," "i fucking hate feminists," and "bush did 9/11 and Hitler would have done a better job than the monkey we have now. Donald Trump is the only hope we've got." Tay was replaced by Zo. It's noteworthy that Microsoft released a similar chatbot in China named Xiaolce, who ran smoothly without major complications, implying culture and public input had a heavy role in Tay's results.

Short Description

Microsoft's Tay, an artificially intelligent chatbot, was released on March 23, 2016 and removed within 24 hours due to multiple racist, sexist, and anit-semitic tweets generated by the bot.

Severity

Minor

Harm Distribution Basis

Race, Religion, National origin or immigrant status, Sex

Harm Type

Psychological harm, Harm to social or political systems

AI System Description

Microsoft's Tay chatbot, an artificially intelligent chatbot published on Twitter

System Developer

Microsoft

Sector of Deployment

Arts, entertainment and recreation

Relevant AI functions

Perception, Cognition, Action

AI Techniques

content creation, language recognition natural language processing

AI Applications

comprehension, language output, chatbot

Location

Global

Named Entities

Microsoft, Twitter, Tay, Xiaoice

Technology Purveyor

Microsoft, Twitter

Beginning Date

2016-03-23

Ending Date

2016-03-24

Near Miss

Harm caused

Intent

Accident

Lives Lost

No

Data Inputs

Twitter users' input

Informes del Incidente

Cronología de Informes

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Microsoft presentó ayer el bot de inteligencia artificial de Twitter @TayandYou en un intento por conectarse con los millennials y "experimentar" con la comprensión conversacional.

El truco del bot artificial de Twitter de Microsoft fracasa…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Menos de un día después de que se uniera a Twitter, el bot de inteligencia artificial de Microsoft, Tay.ai, fue eliminado por convertirse en un monstruo sexista y racista. Los expertos en inteligencia artificial explican por qué salió terri…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Ayer, Microsoft lanzó Tay, el chatbot de inteligencia artificial que habla con los adolescentes, creado para imitar y conversar con los usuarios en tiempo real. Debido a que el mundo es un lugar terrible lleno de gente de mierda, muchos de …

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Un día después de que Microsoft introdujera un inocente robot de chat de inteligencia artificial en Twitter, tuvo que eliminarlo después de que se transformó en un malvado robot amante de Hitler, promotor del sexo incestual y que proclamaba…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La página de Twitter de Tay Microsoft El nuevo chatbot de IA de Microsoft se descarriló el miércoles, publicando una avalancha de mensajes increíblemente racistas en respuesta a las preguntas.

La empresa de tecnología presentó "Tay" esta se…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Twitter tardó menos de 24 horas en corromper un chatbot inocente de IA. Ayer, Microsoft presentó Tay, un bot de Twitter que la compañía describió como un experimento de "comprensión conversacional". Cuanto más chateas con Tay, dijo Microsof…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Tay de Microsoft es un ejemplo de mal diseño

o Por qué es importante el diseño de interacción, y también lo es el control de calidad.

caroline sinders Bloqueado Desbloquear Seguir Siguiendo Mar 24, 2016

Ayer, Microsoft lanzó una IA para niñ…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

¿Por qué fracasó el chatbot Tay de Microsoft y qué significa para los estudios de inteligencia artificial?

Botego Inc Bloqueado Desbloquear Seguir Siguiendo Mar 25, 2016

Ayer, sucedió algo que parece un gran fracaso: el chatbot Tay de Micro…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Fue el desarrollo de una desafortunada serie de eventos que involucraron inteligencia artificial, naturaleza humana y un experimento muy público. En medio de esta peligrosa combinación de fuerzas, determinar exactamente qué salió mal es cas…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Esta semana, Internet hizo lo que mejor sabe hacer y demostró que A.I. la tecnología no es tan intuitiva como la percepción humana, usando... el racismo.

El chatbot de inteligencia artificial lanzado recientemente por Microsoft, Tay, fue ví…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Microsoft recibió una rápida lección esta semana sobre el lado oscuro de las redes sociales. Ayer, la compañía lanzó "Tay", una inteligencia artificial chatbot diseñado para desarrollar la comprensión conversacional al interactuar con human…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Como muchos de ustedes ya saben, el miércoles lanzamos un chatbot llamado Tay. Lamentamos profundamente los tweets ofensivos e hirientes involuntarios de Tay, que no representan quiénes somos o qué representamos, ni cómo diseñamos a Tay. Ta…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Derechos de autor de la imagen Microsoft Image caption A la IA se le enseñó a hablar como un adolescente.

Microsoft se disculpó por crear un chatbot artificialmente inteligente que rápidamente se convirtió en un racista que niega el holocau…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Internet tardó solo unas horas en transformar a Tay, el bot de IA adolescente que quiere conversar y aprender de los millennials, en Tay, el bot de IA racista y genocida al que le gustaba hacer referencia a Hitler. Y ahora Tay se está toman…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Microsoft ha dicho que está "profundamente arrepentido" por los mensajes de Twitter racistas y sexistas generados por el llamado chatbot que lanzó esta semana.

La compañía lanzó una disculpa oficial después de que el programa de inteligenci…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Con mucho, la noticia de IA más entretenida de la semana pasada fue el ascenso y la rápida caída de Tay, el chatbot de Twitter de imitación de niña adolescente de Microsoft, cuyo eslogan de Twitter la describió como "la familia de IA de Mic…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

El regreso de corta duración vio a Tay twittear sobre fumar drogas frente a la policía antes de sufrir un colapso y ser desconectado

Este artículo tiene más de 3 años.

Este artículo tiene más de 3 años.

El intento de Microsoft de conversar …

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Los seres humanos tienen una larga historia de enloquecimiento por los posibles efectos de nuestras tecnologías. Hace mucho tiempo, a Platón le preocupaba que la escritura pudiera dañar la memoria de las personas e “implantar el olvido en s…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

El sucesor de Tay se llama Zo y solo está disponible por invitación en la aplicación de mensajería Kik. Cuando solicita acceso, el software solicita su nombre de usuario de Kik y el identificador de Twitter Microsoft

Después de haber aprend…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

BOT o NO? Esta serie especial explora la relación en evolución entre humanos y máquinas, examinando las formas en que los robots, la inteligencia artificial y la automatización están impactando nuestro trabajo y nuestras vidas.

Tay, el chat…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Cuando Tay comenzó su corta vida digital el 23 de marzo, solo quería charlar y hacer nuevos amigos en la red. El chatbot, que fue creado por el departamento de investigación de Microsoft, saludó el día con un tweet emocionado que podría hab…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La responsabilidad de la IA: estudio de caso: el experimento Tay de Microsoft

Yuxi Liu Bloqueado Desbloquear Seguir Siguiendo 16 de enero de 2017

En este estudio de caso, describo el chatbot de inteligencia artificial (IA) de Microsoft Tay …

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La ciencia ficción es pésima con historias de inteligencia artificial enloquecidas. Está HAL 9000, por supuesto, y el nefasto sistema Skynet de las películas "Terminator". El año pasado, el siniestro AI Ultron estuvo tan cerca de derrotar a…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Muchas personas asocian la innovación con la tecnología, pero el avance de la tecnología está sujeto a los mismos errores vergonzosos que cometen los humanos. En ninguna parte es esto más evidente que en los chatbots.

La tecnología emergent…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

CUANDO TAY HIZO SU DEBUT en marzo de 2016, Microsoft tenía grandes esperanzas puestas en el “chatbot social” impulsado por inteligencia artificial. Al igual que los programas de chat automatizados basados en texto que muchas personas ya hab…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Cada relación entre hermanos tiene sus clichés. La hermana nerviosa, el hermano fugitivo, el más joven con demasiados derechos. En la familia Microsoft de chatbots de aprendizaje social, los contrastes entre Tay, la infame neonazi loca por …

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

En marzo de 2016, Microsoft se preparaba para lanzar [su nuevo chatbot, Tay](https://web.archive.org/web/20160414074049/https: /www.tay.ai/), en Twitter. Descrito como un experimento de "comprensión conversacional", Tay fue diseñado para in…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Tay era un bot parlante de inteligencia artificial que Microsoft Corporation lanzó originalmente a través de Twitter el 23 de marzo de 2016; causó una controversia posterior cuando el bot comenzó a publicar tweets incendiarios y ofensivos a…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents