Journal des citations pour l'incident 43

Entités

Voir toutes les entitésStatistiques d'incidents

Classifications de taxonomie CSETv1

Détails de la taxonomieHarm Distribution Basis

nation of origin, citizenship, immigrant status, sex, race

Sector of Deployment

Education, human health and social work activities

Classifications de taxonomie CSETv0

Détails de la taxonomieFull Description

From 1982 to 1986, St George's Hospital Medical School used a program to autonomously select candidates for admissions interviews. The system, designed by staff member Dr. Geoffrey Franglen, used past admission data to select potential students based on their standardized university applications. After the program achieved 90-95% match with the admission panel’s selection of interview candidates, it was entrusted as the primary method to conduct initial applicant screening. In 1986, lecturers at the school recognized that the system was biased against women and members of ethnic minorities and reported the issue to Britain’s Commission for Racial Equality.

Short Description

From 1982 to 1986, St George's Hospital Medical School used a program to automate a portion of their admissions process that resulted in discrimination against women and members of ethnic minorities.

Severity

Moderate

Harm Distribution Basis

Race, Sex

Harm Type

Harm to civil liberties

AI System Description

A custom designed statistical analysis program that used data from past admissions decisions to select which university applicants to be given admissions interviews.

System Developer

Dr. Geoffrey Franglen

Sector of Deployment

Human health and social work activities

Relevant AI functions

Cognition

AI Techniques

Machine learning

AI Applications

decision support

Location

London, England

Named Entities

St George’s Hospital Medical School, Dr. Geoffrey Franglen, University Central Council for Admission, Commission for Racial Equality

Technology Purveyor

St George’s Hospital Medical School, Dr. Geoffrey Franglen

Beginning Date

1982-01-01T00:00:00.000Z

Ending Date

1986-01-01T00:00:00.000Z

Near Miss

Harm caused

Intent

Accident

Lives Lost

No

Laws Implicated

United Kingdom's Race Relations Act

Data Inputs

Standardized university admission form, Previous admission and regection decisions

Rapports d'incidents

Chronologie du rapport

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

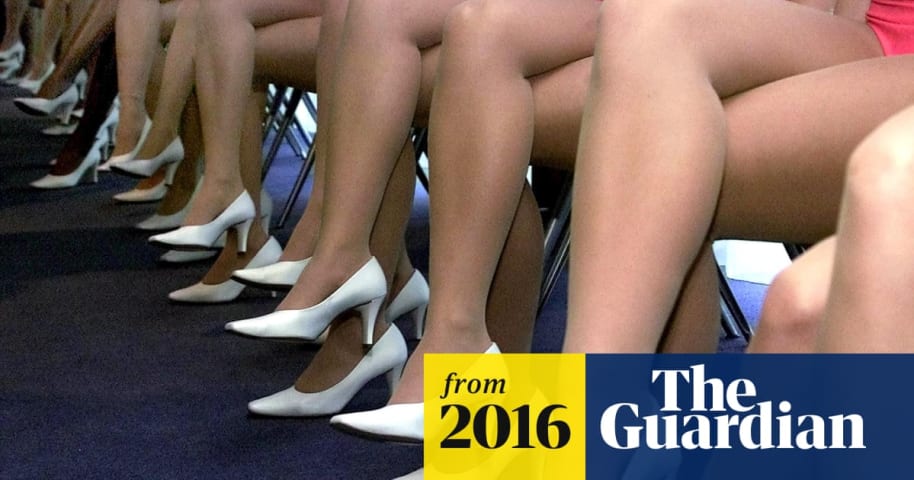

Une tache sur la profession

La discrimination en médecine à l'égard des femmes et des membres des minorités ethniques a longtemps été soupçonnée, mais elle est désormais prouvée. L'école de médecine de l'hôpital St George a été reconnue cou…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

Au fur et à mesure que l'IA se répandra, cela deviendra une question de plus en plus importante et controversée :

Pour une université britannique, ce qui a commencé comme un exercice de gain de temps s'est terminé en disgrâce lorsqu'un modè…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

La professeure Margaret Boden, chercheuse en IA et en sciences cognitives, a pris le temps de me parler en 2010 d'ordinateurs, d'IA, de moralité et d'avenir. L'une des histoires qu'elle m'a racontées me revient de temps en temps, plus récem…

- Afficher le rapport d'origine à sa source

- Voir le rapport sur l'Archive d'Internet

Les entreprises et les gouvernements doivent prêter attention aux biais inconscients et institutionnels qui s'infiltrent dans leurs algorithmes, affirme l'experte en cybersécurité Megan Garcia. Des données déformées peuvent fausser les résu…

Variantes

Incidents similaires

Did our AI mess up? Flag the unrelated incidents

2018 in Review: 10 AI Failures

Discrimination in Online Ad Delivery

Incidents similaires

Did our AI mess up? Flag the unrelated incidents