Registro de citas para el Incidente 43

Entidades

Ver todas las entidadesEstadísticas de incidentes

Clasificaciones de la Taxonomía CSETv1

Detalles de la TaxonomíaHarm Distribution Basis

nation of origin, citizenship, immigrant status, sex, race

Sector of Deployment

Education, human health and social work activities

Clasificaciones de la Taxonomía CSETv0

Detalles de la TaxonomíaFull Description

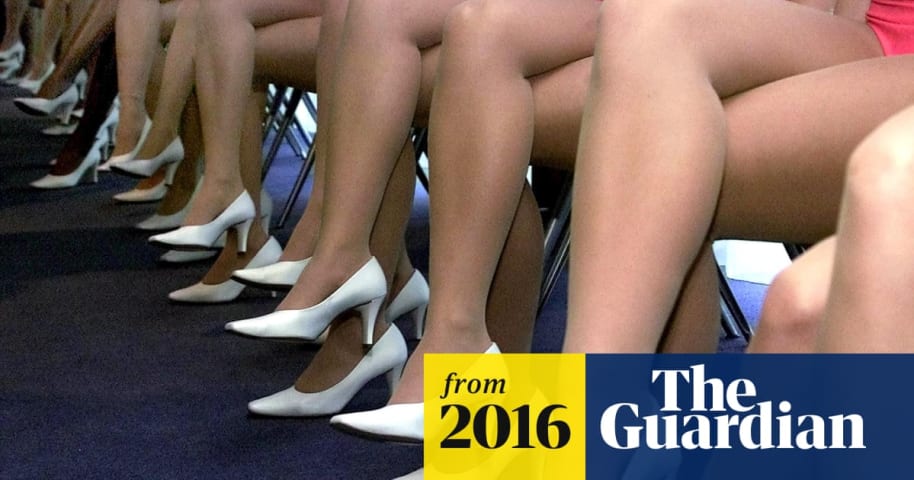

From 1982 to 1986, St George's Hospital Medical School used a program to autonomously select candidates for admissions interviews. The system, designed by staff member Dr. Geoffrey Franglen, used past admission data to select potential students based on their standardized university applications. After the program achieved 90-95% match with the admission panel’s selection of interview candidates, it was entrusted as the primary method to conduct initial applicant screening. In 1986, lecturers at the school recognized that the system was biased against women and members of ethnic minorities and reported the issue to Britain’s Commission for Racial Equality.

Short Description

From 1982 to 1986, St George's Hospital Medical School used a program to automate a portion of their admissions process that resulted in discrimination against women and members of ethnic minorities.

Severity

Moderate

Harm Distribution Basis

Race, Sex

Harm Type

Harm to civil liberties

AI System Description

A custom designed statistical analysis program that used data from past admissions decisions to select which university applicants to be given admissions interviews.

System Developer

Dr. Geoffrey Franglen

Sector of Deployment

Human health and social work activities

Relevant AI functions

Cognition

AI Techniques

Machine learning

AI Applications

decision support

Location

London, England

Named Entities

St George’s Hospital Medical School, Dr. Geoffrey Franglen, University Central Council for Admission, Commission for Racial Equality

Technology Purveyor

St George’s Hospital Medical School, Dr. Geoffrey Franglen

Beginning Date

1982-01-01T00:00:00.000Z

Ending Date

1986-01-01T00:00:00.000Z

Near Miss

Harm caused

Intent

Accident

Lives Lost

No

Laws Implicated

United Kingdom's Race Relations Act

Data Inputs

Standardized university admission form, Previous admission and regection decisions

Informes del Incidente

Cronología de Informes

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Una mancha en la profesión

Durante mucho tiempo se sospechó de la discriminación en la medicina contra las mujeres y los miembros de minorías étnicas, pero ahora se ha demostrado. La Escuela de Medicina del Hospital St George's ha sido decl…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

A medida que la IA se propague, este se convertirá en un tema cada vez más importante y controvertido:

Para una universidad británica, lo que comenzó como un ejercicio de ahorro de tiempo terminó en desgracia cuando un modelo de computadora…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

La profesora Margaret Boden, investigadora de inteligencia artificial y ciencias cognitivas, se tomó el tiempo para hablarme en 2010 sobre computadoras, inteligencia artificial, moralidad y el futuro. Una de las historias que me contó vuelv…

- Ver el informe original en su fuente

- Ver el informe en el Archivo de Internet

Las empresas y los gobiernos deben prestar atención a los sesgos inconscientes e institucionales que se filtran en sus algoritmos, argumenta la experta en ciberseguridad Megan García. Los datos distorsionados pueden sesgar los resultados en…

Variantes

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents

2018 in Review: 10 AI Failures

Discrimination in Online Ad Delivery

Incidentes Similares

Did our AI mess up? Flag the unrelated incidents